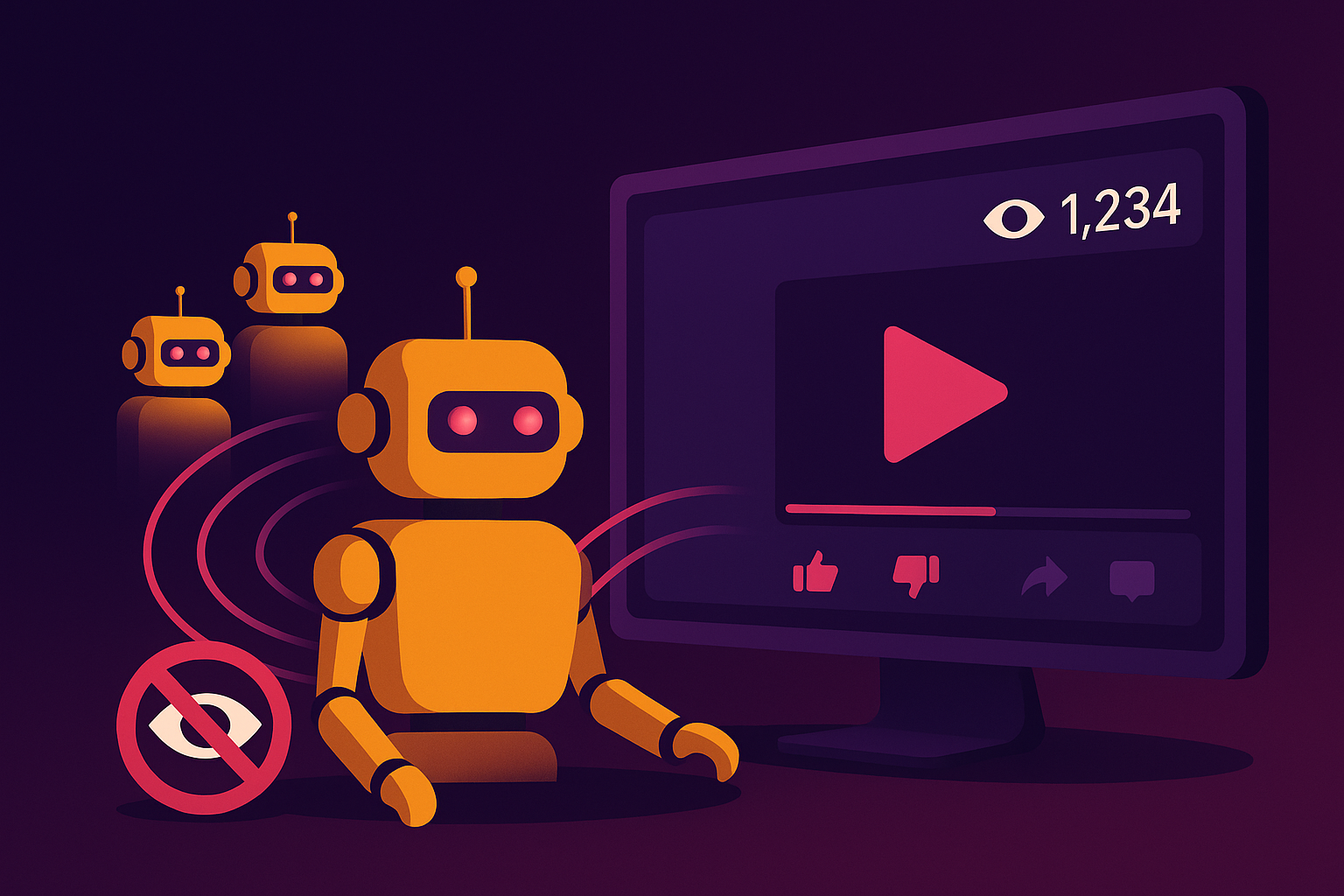

¿Qué son los View Bots y cómo afectan a tus campañas publicitarias?

El tráfico web no siempre es humano. Estudios recientes indican que más del 40% de las visitas a sitios web y campañas digitales provienen de bots. Entre ellos, los view bots se han convertido en una de las amenazas más extendidas para anunciantes, creadores de contenido y plataformas de vídeo. Un view bot es un programa diseñado para simular visualizaciones en vídeos o transmisiones en directo, alterando artificialmente las métricas de popularidad. Plataformas como YouTube, Twitch o TikTok han librado auténticas batallas para detectar y bloquear este tipo de fraude, pero la realidad es que el fenómeno sigue creciendo. El futuro del marketing digital depende de recuperar la transparencia y la confianza en los datos.